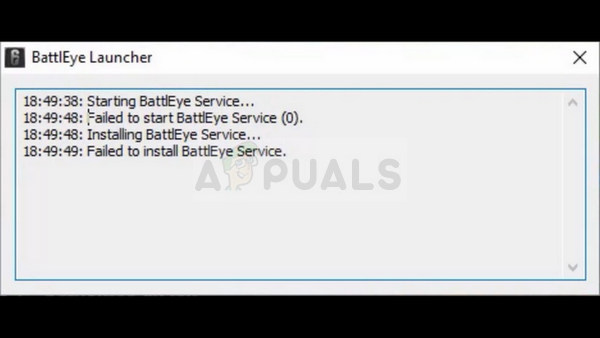

Genoptagelse af NASAs rumfotografering for at give et klarere resultat. Rumflyvning nu

NVIDIA har længe været kendt for sine pletfri grafiske processorenheder (GPU'er), hvis hovedprodukt er NVIDIA GeForce-kortet. Med det har virksomheden altid været førende inden for forskning og udvikling af erfaringer, der forbedrer kunstig intelligens inden for videospil, grafisk design, databehandling og bilkøretøjer.

På det seneste er NVIDIA begyndt at fokusere på kunstig intelligens isoleret med sit seneste projekt, der tager et stort fokus på smart reimaging af allerede eksisterende fotos ved hjælp af gaussiske algoritmer til at evaluere de mindst forskellige forskelle mellem hundreder af klare og slørede billeder kategoriseret baseret på temperatur og farvetone, og derefter indsætte disse værdier i regressionsudtrykkene for individuelle slørede fotos for at vende tilbage til, hvordan deres originale klare billeder kunne have set ud. Denne proces udføres individuelt for hvert punkt på fotografiet, og en summering bruges til at generere en generisk mindste forskelværdi.

NVIDIA Office. Nasdaq på Twitter

Algoritmen arbejder for at lære af tidligere forsøg på, hvad bestemte farver og mønstre på skærmen indikerer. Da systemet blev udviklet, var det tusindvis af slørede og originale billeder, så maskinen kunne identificere, hvilke mønstre og farver på skærmen der svarer til hvilke riller og kanter i det originale billede. Efter at være blevet testet mange gange har NVIDIA formået at lære sin AI-chip at lære af tidligere forsøg og gemme en database med matchede grafiske koder, der konverteres til matematisk kode baseret på placering, farvetone og temperatur. Ved hjælp af tidligere erfaringer og forholdet, der er etableret mellem de slørede og klare billeder af samme sted og farvetone, knækker maskinen på med nye billeder og anvender de formler, der passer bedst til det nye fotos farvetone og temperatur. NVIDIA har sat deres algoritme igennem tilstrækkelige forsøg til at have en stærk nok opbevaringsdatabase, som AI kan benytte sig af, når de arbejder på nyere billeder, og mekanismen står nu alene, i stand til at afdække stort set ethvert billede ved sin træning i forstærkningslæring (RL) . Efter at have afdækket nok ansigter, kan maskinen f.eks. Skinne slørede ansigter, når den sættes på prøve, da den forstår, hvilke slørede riller der i sandhed svarer til hvilke ansigtsdrag. Eksponering for forskellige slags støj, såsom overstrakte, hvidkalkede, filtrerede og teksturerede billeder har også tilføjet algoritmedatabasen.

I algoritmen matematisk sprog, læser programmet tilsvarende korrupte og klare loci på tilsvarende billeder og logger x, y, x ’og y’ i sin database. Derefter oprettes en gaussisk regressionskurve, der passer til forskellene mellem de to, der muliggør konvertering baseret på generel fotografisk støj. I det genererede regressionsudtryk med de mindste kvadrater tages den laveste værdi, der opfylder betingelsen, og en ny kurve for den gaussiske værdi er tegnet. Når billedet konverteres tilbage til dets oprindelige klare kvalitet, ændres hvert punkts temperatur baseret på forskellen i regressionsmønsteret i AI-maskinens database, der svarer til den bestemte farve og mønster, og hvert punkt vendes for at producere et helt klart billede. Den gaussiske kurvemekanisme påvirker de mest generiske former for støj, men hvis enheden er i stand til at identificere andre former for støj, der ofte tilskrives dårligt indstillet lukkerhastighed eller generisk skygge for den immage, beregnes den gaussiske mindste forskelværdi i gennemsnit datasætets poisson (for førstnævnte) og Bernoulli (for sidstnævnte) også mindst forskelværdier.

Kunstig intelligens assisteret foto genindspilning. BT

I lægmandsbetingelser er den rolle, som kunstig intelligens spiller i dette, smart detektion og konvertering af unikke fotos baseret på en praksis, som enheden allerede har forsøgt. Når det kommer til niveauet for kunstig intelligens, der opnås i dag, og som stadig er på et stadium, hvor det ikke er særlig uafhængigt og har sin indsats begrænset til de allerede anvendte scenarier, har NVIDIA opnået meget med at skabe en maskine, der kan forsøge og genskabe usete fotos med det højeste niveau af nøjagtighed ved konsekvent at tilpasse og udvide sin database for at forbedre succesraten for efterfølgende fotografiske omsætninger.